哪种人工智能更适合生成图像?

本文将从技术和实践角度探讨四种流行的图像编辑模型—— 奎文, UMO, 通量上下文 和 纳米香蕉 — 我们从准确性、速度、资源需求、集成能力和最合适的用途等方面对其进行考察。.

型号概述(功能和快速对比)

下面,我们将简要介绍每款型号,以便您根据自身需求和硬件限制更轻松地选择合适的型号。.

奎文

类型: 多功能模型,带有图像编辑模块(不同级别:从基本编辑到复杂编辑)。.

力量: 对图像和合成编辑中的自然输出有广泛的上下文理解;适用于高质量的 API 服务。.

资源需求: 优化版配备 16GB 显存,完整版配备 48GB 以上显存。.

最佳用途: 以图像为中心的 SaaS 平台、合成编辑和详细的广告内容制作。.

UMO

类型: 针对凹坑修复和照片级真实感修复的优化模型。.

力量: 能够高精度地重建已删除的部分,并保留光照和纹理。.

资源需求: 通常需要 12-32GB 的显存才能进行有效的推理。.

最佳用途: 网络上的摄影工作室、修图、历史图像修复和单张图像编辑工具。.

通量上下文

类型: 面向多步骤和指令引导编辑的上下文感知注意力模型。.

力量: 协调多步骤编辑、强力支持提示链和大上下文窗口。.

资源需求: 最好使用支持 TensorRT/FP16 的 GPU,以最大限度地减少延迟。.

最佳用途: 需要低延迟的专业交互式编辑和协作应用程序。.

纳米香蕉

类型: 轻巧紧凑型,适用于边缘部署和移动设备。.

力量: 在内存有限的 GPU 上快速执行,适用于量化和 INT8/4 位。.

资源需求: 量化版本需要 4-8GB 显存。.

最佳用途: 浏览器扩展程序、移动应用程序和低成本 VPS 用于轻量级推理。.

技术评价标准(延迟、吞吐量、质量)

要选择最合适的模型,需要测量和优化以下四个关键标准:

- 延迟(毫秒): 从请求到响应的路径时间。用于交互式编辑目标 小于200毫秒 是;批量处理可以接受较大的值。.

- 吞吐量(张/秒): 单位时间内处理的图像数量——对于渲染和批量服务至关重要。.

- 质量: 定量指标如 PSNR、SSIM 和感知指标如 LPIPS 和 FID 以及人工评价。.

- 资源效率: VRAM、RAM、vCPU 和网络 I/O 消耗量决定了所需服务器的类型。.

实用服务器部署指南(命令和配置)

本节提供在配备 GPU 的 Linux 服务器上快速部署模型的实用示例。.

准备服务器(安装 NVIDIA 驱动程序和 Docker)

sudo apt update

sudo apt install -y build-essential dkms

# install NVIDIA drivers (recommended per GPU)

sudo ubuntu-drivers autoinstall

# install Docker and nvidia-docker

curl -fsSL https://get.docker.com | sh

distribution=$(. /etc/os-release;echo $ID$VERSION_ID)

curl -s -L https://nvidia.github.io/nvidia-docker/gpgkey | sudo apt-key add -

curl -s -L https://nvidia.github.io/nvidia-docker/$distribution/nvidia-docker.list | sudo tee /etc/apt/sources.list.d/nvidia-docker.list

sudo apt update && sudo apt install -y nvidia-docker2

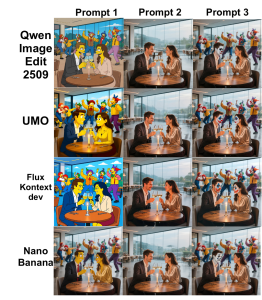

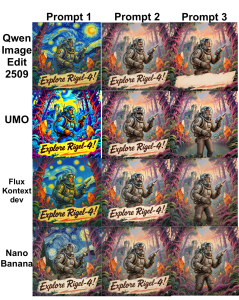

sudo systemctl restart docker有关示例和对比图片,您可以参考以下图片:

运行推理容器示例(使用 NVIDIA 运行时)

docker run --gpus all -it --rm \

-v /srv/models:/models \

-p 8080:8080 \

--name img-edit-infer \

myrepo/image-edit:latest \

bash在容器内部,您可以使用 Uvicorn 或 Flask 运行推理服务:

uvicorn app:app --host 0.0.0.0 --port 8080 --workers 2实施优化技巧(FP16、TensorRT、量化)

为了减少显存占用和延迟,您可以使用以下方法:

- FP16: 启用 Flux Kontext 和 Qwen 可以降低显存消耗和延迟。PyTorch 示例:

model.half()

with torch.cuda.amp.autocast():

out = model(input)- TensorRT/ONNX: 将大型模型转换为 ONNX 格式,然后再转换为 TensorRT 格式,以降低延迟:

python export_to_onnx.py --model qwen --output qwen.onnx

trtexec --onnx=qwen.onnx --fp16 --saveEngine=qwen.trt- 量化(纳米香蕉): 使用 bitsandbytes 或量化感知方法来实现 4 位或 8 位,以便在边缘或低成本 VPS 上运行。.

基于用户的硬件推荐

- 初步开发和测试: RTX(3060/3070)或 A2000 GPU,配备 8-12GB 显存。.

- 高质量推理部署(SaaS): A10/A30 或 RTX 6000 (24GB) 可实现高吞吐量。.

- 训练/微调和大型模型(Qwen完整版): A100/H100 配备 40–80GB 显存或多 GPU,支持 NVLink。.

- Nano Banana 的 Edge 和低成本 VPS: 配备 8GB 显存的服务器或支持 eGPU 的 VPS。.

我们公司:为什么我们的基础设施适合这些模式?

- 全球超过 85 个地点: 降低分布式团队和终端用户的延迟。.

- 各种图形服务器: 从渲染和推理卡到用于高强度训练的 H100。.

- 高性能云服务器和BGP/CDN网络: 适用于需要高带宽和地理分布的人工智能服务。.

- 服务器和云安全防护: 保持 API 可用性并防止第 7 层攻击。.

- 用于交易和游戏的VPS方案: 适用于对延迟敏感和实时性要求高的应用。.

- 附加服务: GitLab 为 CI/CD 模型、渲染服务、托管数据库和网络解决方案提供托管服务。.

实际示例:基于 Flux Kontext 的图像编辑服务的流程

一个拟定的图像编辑服务流程包括以下步骤:

- 接收用户图像并请求编辑(API)。.

- 预处理:调整大小、归一化并生成分割掩码。.

- 发送到 Flux Kontext 模型(FP16、TensorRT)以获取快速预览。.

- 后期处理:调色、锐化和 WebP/JPEG 输出。.

- 存储在 CDN 上,并将链接返回给用户。.

请求结构示例(伪代码):

POST /edit

{ "image_url": "...", "instructions": "remove background and enhance skin", "size":"1024" }目标速度: 延迟小于 200 毫秒 预览和 < 2秒 最终高质量渲染(取决于硬件)。.

模型的安全性、成本和管理

模型安全性、管理和成本方面的关键点:

- 隐私和数据: 始终对敏感图像(静态和传输中)进行加密,并使用带有 SSE 或托管密钥的 S3。.

- 访问限制: API 密钥、速率限制和 WAF 对于推理端点至关重要。.

- 模型版本控制: 使用 Harbor 或 Git LFS 等注册表来管理模型版本,以便轻松回滚。.

- 成本: 大型模型具有较高的显存和功耗;对于突发性服务,请使用自动扩展 GPU 服务器或竞价型实例。.

图像编辑服务的网络和CDN设置

- 使用 CDN 为了快速交付最终图像。.

- BGP 和任播 降低延迟,改善全球用户的连接性。.

- 具有粘性会话的负载均衡器 适用于需要状态维护的多步骤工作流程。.

根据自身需求选择合适型号的实用技巧

- 单张图像逼真编辑(修图): UMO是最佳选择。.

- 可控的命令操作和带有大量上下文的分步编辑: Flux Kontext 适用。.

- 整体质量和要素组合以及充足的资源: Qwen是个不错的选择。.

- 在边缘设备或低成本VPS上运行: Nano Banana 适用于量化。.

评估和基准测试方法(建议)

为了进行基准测试,建议使用以下测试套件和标准:

- 测试集: 100 张不同场景的图片(入射、背景变化、光照)。.

- 标准: 平均延迟、p95 延迟、吞吐量、PSNR、SSIM 和人工评价。.

- 工具: 使用 locust 或 wrk 进行加载;使用 torchvision 和 skimage 计算 PSNR/SSIM。.

关于创业的最后建议

关于企业设立的一些实用建议:

- 面向全球用户的SaaS服务: 结合 CDN、位于多个关键位置的 GPU 服务器以及基于请求队列的自动扩缩容。.

- 工作室和渲染: 专用 GPU 服务器,配备 NVLink 和高速存储,用于工作流程。.

- MVP(最小可行产品)或概念验证: 在配备 8-16GB 显存的 VPS 上使用 Nano Banana 或 Qwen 的量化版本,可以降低成本。.

如果您想通过真实数据测试性能来验证适合您企业的商业模式,我们的技术团队可以提供定制方案和测试。.