画像作成に適した AI はどれですか?

この記事では、4つの一般的な画像編集モデルについて技術的および実用的な観点から説明します。 クウェン、 ユーモ、 フラックスコンテキスト そして ナノバナナ — 精度、速度、リソース要件、統合機能、最適な使用方法の観点から検証します。.

モデルの概要(機能と簡単な比較)

以下では、ニーズとハードウェアの制限に基づいて適切なモデルを選択しやすくするために、各モデルを簡単に紹介します。.

クウェン

タイプ: 画像編集モジュール(基本的な編集から複雑な編集まで、さまざまなレベル)を備えた多目的モデル。.

強さ: 画像の広範なコンテキスト理解と合成編集における自然な出力。高品質の API サービスに適しています。.

リソース要件: 最適化されたバージョンでは 16 GB VRAM から、フル モデルでは 48 GB 以上まで。.

最適な用途: 画像中心の SaaS プラットフォーム、複合編集、詳細な広告コンテンツ制作。.

ユーモ

タイプ: インピット加工とフォトリアリスティックな修復に最適化されたモデル。.

強さ: 照明とテクスチャを保持しながら、削除された部分を再構築する高い精度。.

リソース要件: 効果的な推論には、通常 12~32 GB の VRAM が必要です。.

最適な用途: 写真スタジオ、レタッチ、歴史的画像の修復、Web 上の単一画像編集ツール。.

フラックスコンテキスト

タイプ: 複数のステップと指示ガイドによる編集のためのコンテキスト認識型注意モデル。.

強さ: 複数ステップの編集間の調整、プロンプトチェーンの強力なサポート、大きなコンテキスト ウィンドウ。.

リソース要件: レイテンシを最小限に抑えるには、TensorRT/FP16 をサポートする GPU が望ましいです。.

最適な用途: 低遅延を必要とするプロフェッショナルなインタラクティブ編集および共同作業アプリケーション。.

ナノバナナ

タイプ: エッジ展開およびモバイル向けの軽量コンパクトモデル。.

強さ: メモリが限られた GPU 上で高速に実行し、量子化と INT8/4 ビットに適しています。.

リソース要件: 量子化バージョンでは 4~8 GB の VRAM で実行されます。.

最適な用途: 軽量推論のためのブラウザ拡張機能、モバイル アプリ、低コストの VPS。.

評価のための技術的基準(レイテンシ、スループット、品質)

最も適切なモデルを選択するには、次の 4 つの主要な基準を測定して最適化する必要があります。

- レイテンシ(ミリ秒): リクエストからレスポンスまでのパス時間。ターゲットのインタラクティブな編集用 200ミリ秒未満 バッチ処理では、より大きな値を受け入れることができます。.

- スループット(画像/秒): 単位時間あたりに処理される画像の数。レンダリングおよびバッチ サービスにとって重要です。.

- 品質: PSNR、SSIMなどの定量的なメトリクス、LPIPS、FIDなどの知覚的なメトリクス、および人間による評価。.

- 資源効率: VRAM、RAM、vCPU、ネットワーク I/O の消費量によって、必要なサーバーの種類が決まります。.

実用的なサーバー展開ガイド(コマンドと構成)

このセクションでは、GPU を搭載した Linux サーバーにモデルを迅速に展開するための実用的な例を示します。.

サーバーの準備(NVIDIA ドライバーと Docker のインストール)

sudo apt update

sudo apt install -y build-essential dkms

# install NVIDIA drivers (recommended per GPU)

sudo ubuntu-drivers autoinstall

# install Docker and nvidia-docker

curl -fsSL https://get.docker.com | sh

distribution=$(. /etc/os-release;echo $ID$VERSION_ID)

curl -s -L https://nvidia.github.io/nvidia-docker/gpgkey | sudo apt-key add -

curl -s -L https://nvidia.github.io/nvidia-docker/$distribution/nvidia-docker.list | sudo tee /etc/apt/sources.list.d/nvidia-docker.list

sudo apt update && sudo apt install -y nvidia-docker2

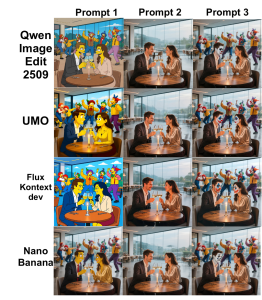

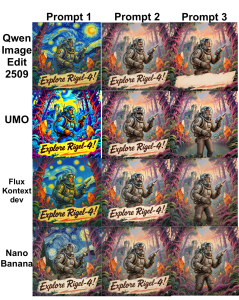

sudo systemctl restart dockerサンプル画像や比較画像については、以下の画像を参照してください。

推論コンテナの例を実行する(NVIDIA ランタイムを使用)

docker run --gpus all -it --rm \

-v /srv/models:/models \

-p 8080:8080 \

--name img-edit-infer \

myrepo/image-edit:latest \

bashコンテナ内では、Uvicorn または Flask を使用して推論サービスを実行できます。

uvicorn app:app --host 0.0.0.0 --port 8080 --workers 2最適化のヒントの実装(FP16、TensorRT、量子化)

VRAM とレイテンシを削減するには、次の方法を使用できます。

- FP16: Flux KontextとQwenを有効にすると、VRAMの消費量とレイテンシを削減できます。PyTorchの例:

model.half()

with torch.cuda.amp.autocast():

out = model(input)- TensorRT/ONNX: 重いモデルを ONNX に変換してから TensorRT に変換してレイテンシを削減します。

python export_to_onnx.py --model qwen --output qwen.onnx

trtexec --onnx=qwen.onnx --fp16 --saveEngine=qwen.trt- 量子化(ナノバナナ): ビットアンドバイトまたは量子化を考慮したメソッドを使用して 4 ビットまたは 8 ビットを実装し、エッジまたは低コストの VPS で実行します。.

ユーザーに基づいたハードウェアの推奨

- 初期開発とテスト: 8~12GBのVRAMを搭載したRTX(3060/3070)またはA2000 GPU。.

- 高品質な推論の展開 (SaaS): 高スループットを実現する A10/A30 または RTX 6000 (24GB)。.

- トレーニング/ファインチューンと大規模モデル (Qwen フル): 40~80GBのVRAMを搭載したA100/H100、またはNVLink対応のマルチGPU。.

- Nano Banana 向けの Edge および低コストの VPS: 8GB VRAM を搭載したサーバーまたは eGPU をサポートする VPS。.

当社: 当社のインフラストラクチャがこれらのモデルに適しているのはなぜでしょうか?

- 世界85か所以上の拠点: 分散チームとエンドユーザーの待ち時間が短縮されます。.

- さまざまなグラフィック サーバー: レンダリングや推論カードから、集中的なトレーニングを行う H100 まで。.

- 高性能クラウドサーバーとBGP/CDNネットワーク: 帯域幅と地理的な分散を必要とする AI サービスに適しています。.

- DDoS対策サーバーとクラウドセキュリティ: API の可用性を維持し、レイヤー 7 攻撃を防ぎます。.

- 取引とゲーム用の VPS プラン: 遅延に敏感なリアルタイム アプリケーション向け。.

- 追加サービス: CI/CD モデル、レンダリング サービス、マネージド データベース、ネットワーク ソリューション向けの GitLab ホスティング。.

実例: Flux Kontext ベースの画像編集サービスのパイプライン

画像編集サービスの提案されたパイプラインには、次のステップが含まれます。

- ユーザーから画像を受信し、編集を要求します (API)。.

- 前処理: サイズ変更、正規化、セグメンテーション マスクの生成。.

- 簡単なプレビューを取得するには、Flux Kontext モデル (FP16、TensorRT) に送信します。.

- 後処理: カラーグレーディング、シャープニング、WebP/JPEG 出力。.

- CDN に保存し、ユーザーにリンクを返します。.

サンプルリクエスト構造(疑似):

POST /edit

{ "image_url": "...", "instructions": "remove background and enhance skin", "size":"1024" }目標速度: レイテンシ < 200ms プレビューと 2秒未満 最終的な高品質レンダリング用 (ハードウェアによって異なります)。.

モデルのセキュリティ、コスト、管理

モデルのセキュリティ、管理、コストに関する重要なポイント:

- プライバシーとデータ: 機密画像(保存時および転送中)は常に暗号化し、SSE またはマネージド キーを備えた S3 を使用します。.

- アクセス制限: API キー、レート制限、WAF は推論エンドポイントに不可欠です。.

- モデルのバージョン管理: ロールバックを容易にするために、モデル バージョンには Harbor や Git LFS などのレジストリを使用します。.

- 料金: 大規模モデルでは VRAM と電力消費量が多くなります。バースト的なサービスの場合は、自動スケーリング GPU サーバーまたはスポット インスタンスを使用します。.

画像編集サービスのネットワークとCDN設定

- CDNの使用 最終画像を迅速に納品します。.

- BGPとエニーキャスト ping を減らし、世界中のユーザーの接続性を向上させます。.

- スティッキーセッションを備えたロードバランサ 状態の維持を必要とする複数ステップのワークフロー向け。.

ニーズに基づいてモデルを選択するための実用的なヒント

- 単一画像のフォトリアリスティック編集(レタッチ): UMOが最良の選択です。.

- 大きなコンテキストでのコマンド機能とステップバイステップの編集: Flux Kontext が適しています。.

- 全体的な品質と十分なリソースを備えた要素の組み合わせ: Qwen は強力な選択肢です。.

- エッジデバイスまたは低コストの VPS で実行: Nano Banana は量子化に適しています。.

評価およびベンチマーク方法(提案)

ベンチマークには、次のテスト スイートと基準を使用することをお勧めします。

- テストセット: さまざまなシナリオ(インピット、背景変更、照明)の画像 100 枚。.

- 基準: 平均レイテンシ、p95 レイテンシ、スループット、PSNR、SSIM、および人間による評価。.

- ツール: ロードには locust または wrk、PSNR/SSIM の計算には torchvision と skimage を使用します。.

ビジネスを始めるための最後のアドバイス

事業設立に関する実際的な提案:

- 世界中のユーザーを抱えるSaaSサービス: CDN、複数の主要な場所にある GPU サーバー、およびリクエスト キュー ベースの自動スケーリングを組み合わせます。.

- スタジオとレンダリング: ワークフロー用の NVLink と高速ストレージを備えた専用 GPU サーバー。.

- MVP または概念実証: コストを削減するには、8~16 GB の VRAM を搭載した VPS で Nano Banana または Qwen の量子化バージョンを使用します。.

実際のデータでパフォーマンスをテストして、ビジネスに適したビジネス モデルを検証したい場合は、当社の技術チームがカスタム プランとテストを提供できます。.