- ¿Qué IA es mejor para crear imágenes?

- Descripción general del modelo (características y comparación rápida)

- Criterios técnicos de evaluación (latencia, rendimiento, calidad)

- Guía práctica de implementación de servidores (comandos y configuraciones)

- Recomendaciones de hardware basadas en el usuario

- Nuestra empresa: ¿Por qué nuestra infraestructura es adecuada para estos modelos?

- Ejemplos prácticos: canalización para un servicio de edición de imágenes basado en Flux Kontext

- Seguridad, coste y gestión de modelos

- Configuración de red y CDN para el servicio de edición de imágenes

- Consejos prácticos para elegir un modelo según tus necesidades

- Métodos de evaluación y benchmarking (sugeridos)

- Consejos finales para iniciar un negocio

- Preguntas frecuentes

¿Qué IA es mejor para crear imágenes?

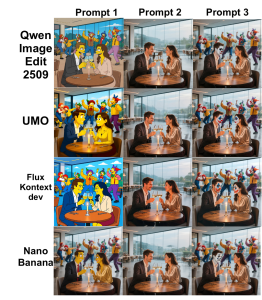

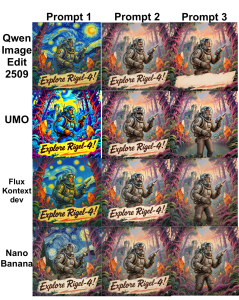

En este artículo, analizaremos los cuatro modelos populares de edición de imágenes en términos técnicos y prácticos: Qwen, UMO, Contexto de flujo y Nano plátano —Lo examinamos en términos de precisión, velocidad, requisitos de recursos, capacidades de integración y uso más apropiado.

Descripción general del modelo (características y comparación rápida)

A continuación, presentamos brevemente cada modelo para que sea más fácil elegir el adecuado en función de tus necesidades y limitaciones de hardware.

Qwen

Tipo: Modelo multipropósito con módulos de edición de imágenes (en diferentes niveles: básico hasta edición compleja).

Fortaleza: Amplia comprensión contextual de la imagen y resultados naturales en ediciones compuestas; adecuado para servicios API de alta calidad.

Requisitos de recursos: Desde 16 GB de VRAM para versiones optimizadas hasta más de 48 GB para modelos completos.

Mejor uso: Plataformas SaaS centradas en imágenes, ediciones compuestas y producción de contenido publicitario detallado.

UMO

Tipo: Modelo optimizado para picadura y restauración fotorrealista.

Fortaleza: Alta precisión en la reconstrucción de partes eliminadas, conservando la iluminación y la textura.

Requisitos de recursos: Generalmente se utilizan entre 12 y 32 GB de VRAM para una inferencia efectiva.

Mejor uso: Estudios de fotografía, retoque, restauración de imágenes históricas y herramientas de edición de imágenes individuales en la web.

Contexto de flujo

Tipo: Modelo de atención consciente del contexto para ediciones de múltiples pasos y guiadas por instrucciones.

Fortaleza: Coordinación entre ediciones de varios pasos, fuerte soporte para encadenamiento de indicaciones y grandes ventanas de contexto.

Requisitos de recursos: Preferiblemente GPU con soporte TensorRT/FP16 para minimizar la latencia.

Mejor uso: Edición interactiva profesional y aplicaciones colaborativas que requieren baja latencia.

Nano plátano

Tipo: Modelo ligero y compacto para implementación en borde y móvil.

Fortaleza: Ejecución rápida en GPU con memoria limitada, adecuada para cuantificación e INT8/4 bits.

Requisitos de recursos: Funciona con 4–8 GB de VRAM en versiones cuantificadas.

Mejor uso: Extensiones de navegador, aplicaciones móviles y VPS de bajo costo para inferencia liviana.

Criterios técnicos de evaluación (latencia, rendimiento, calidad)

Para elegir el modelo más adecuado, es necesario medir y optimizar cuatro criterios clave:

- Latencia (ms): El tiempo transcurrido desde la solicitud hasta la respuesta. Para la edición interactiva del objetivo. <200 ms Se pueden aceptar valores mayores para el procesamiento por lotes.

- Rendimiento (img/s): Número de imágenes procesadas por unidad de tiempo: importante para la renderización y los servicios por lotes.

- Calidad: Métricas cuantitativas como PSNR, SSIM y métricas perceptuales como LPIPS y FID, así como evaluación humana.

- Eficiencia de recursos: Consumo de VRAM, RAM, vCPU y E/S de red, lo que determina el tipo de servidor necesario.

Guía práctica de implementación de servidores (comandos y configuraciones)

Esta sección proporciona ejemplos prácticos para implementar rápidamente modelos en un servidor Linux con GPU.

Preparación del servidor (instalación de controladores NVIDIA y Docker)

sudo apt update

sudo apt install -y build-essential dkms

# install NVIDIA drivers (recommended per GPU)

sudo ubuntu-drivers autoinstall

# install Docker and nvidia-docker

curl -fsSL https://get.docker.com | sh

distribution=$(. /etc/os-release;echo $ID$VERSION_ID)

curl -s -L https://nvidia.github.io/nvidia-docker/gpgkey | sudo apt-key add -

curl -s -L https://nvidia.github.io/nvidia-docker/$distribution/nvidia-docker.list | sudo tee /etc/apt/sources.list.d/nvidia-docker.list

sudo apt update && sudo apt install -y nvidia-docker2

sudo systemctl restart dockerPara ver imágenes de muestra y comparación, puede consultar las siguientes imágenes:

Ejecución del ejemplo del contenedor de inferencia (con Nvidia Runtime)

docker run --gpus all -it --rm \

-v /srv/models:/models \

-p 8080:8080 \

--name img-edit-infer \

myrepo/image-edit:latest \

bashDentro del contenedor, puedes ejecutar el servicio de inferencia con Uvicorn o Flask:

uvicorn app:app --host 0.0.0.0 --port 8080 --workers 2Implementando consejos de optimización (FP16, TensorRT, Cuantización)

Para reducir la VRAM y la latencia, puede utilizar lo siguiente:

- FP16: Habilite Flux Kontext y Qwen para reducir el consumo de VRAM y la latencia. Ejemplo de PyTorch:

model.half()

with torch.cuda.amp.autocast():

out = model(input)- TensorRT/ONNX: Conversión de modelos pesados a ONNX y luego a TensorRT para reducir la latencia:

python export_to_onnx.py --model qwen --output qwen.onnx

trtexec --onnx=qwen.onnx --fp16 --saveEngine=qwen.trt- Cuantización (Nano Banana): Utilice bits y bytes o métodos que tengan en cuenta la cuantificación para implementar 4 u 8 bits para ejecutar en el borde o en un VPS de bajo costo.

Recomendaciones de hardware basadas en el usuario

- Desarrollo inicial y pruebas: GPU RTX (3060/3070) o A2000 con 8–12 GB de VRAM.

- Implementación de inferencia de alta calidad (SaaS): A10/A30 o RTX 6000 (24 GB) para alto rendimiento.

- Entrenamiento/Ajuste fino y modelos grandes (Qwen completo): A100/H100 con 40–80 GB de VRAM o multi-GPU con NVLink.

- VPS de bajo costo y de borde para Nano Banana: Servidores con 8GB VRAM o VPS con soporte eGPU.

Nuestra empresa: ¿Por qué nuestra infraestructura es adecuada para estos modelos?

- Más de 85 ubicaciones en todo el mundo: Latencia reducida para equipos distribuidos y usuarios finales.

- Varios servidores gráficos: Desde tarjetas de renderizado e inferencia hasta el H100 para entrenamiento pesado.

- Servidor en nube de alto rendimiento y red BGP/CDN: Adecuado para servicios de IA que requieren ancho de banda y distribución geográfica.

- Seguridad en servidores y en la nube anti-DDoS: Mantenga la disponibilidad de la API y evite ataques de capa 7.

- Planes VPS para comercio y juegos: Para aplicaciones sensibles a la latencia y en tiempo real.

- Servicios adicionales: Alojamiento de GitLab para modelos CI/CD, servicio de renderizado, bases de datos administradas y soluciones de redes.

Ejemplos prácticos: canalización para un servicio de edición de imágenes basado en Flux Kontext

Una propuesta de canalización para un servicio de edición de imágenes incluye los siguientes pasos:

- Recibir imagen y solicitar edición al usuario (API).

- Preprocesamiento: redimensionar, normalizar y generar máscara de segmentación.

- Envíe al modelo Flux Kontext (FP16, TensorRT) para obtener una vista previa rápida.

- Posprocesamiento: gradación de color, nitidez y salida WebP/JPEG.

- Almacenar en CDN y devolver el enlace al usuario.

Estructura de solicitud de muestra (pseudo):

POST /edit

{ "image_url": "...", "instructions": "remove background and enhance skin", "size":"1024" }Velocidad objetivo: latencia < 200ms Para vista previa y < 2 s Para una representación final de alta calidad (dependiendo del hardware).

Seguridad, coste y gestión de modelos

Puntos clave en las áreas de seguridad, gestión y coste de los modelos:

- Privacidad y datos: Cifre siempre las imágenes confidenciales (en reposo y en tránsito) y utilice S3 con SSE o claves administradas.

- Restricciones de acceso: Las claves API, la limitación de velocidad y el WAF son esenciales para los puntos finales de inferencia.

- Versiones del modelo: Utilice un registro como Harbor o Git LFS para las versiones del modelo para facilitar las reversiones.

- Costo: Los modelos grandes tienen un alto consumo de VRAM y energía; para servicios con ráfagas, utilice servidores GPU con escalamiento automático o instancias puntuales.

Configuración de red y CDN para el servicio de edición de imágenes

- Uso de CDN Para una entrega rápida de imágenes finales.

- BGP y Anycast Para reducir el ping y mejorar la conectividad para usuarios globales.

- Balanceador de carga con sesiones persistentes Para flujos de trabajo de varios pasos que requieren mantenimiento del estado.

Consejos prácticos para elegir un modelo según tus necesidades

- Edición fotorrealista de una sola imagen (retoque): UMO es la mejor opción.

- Ediciones de línea de comandos y por etapas con amplio contexto: Flux Kontext es adecuado.

- Calidad general y combinación de elementos con recursos suficientes: Qwen es una elección sólida.

- Ejecútelo en dispositivos periféricos o VPS de bajo costo: Nano Banana es adecuado para la cuantificación.

Métodos de evaluación y benchmarking (sugeridos)

Para la evaluación comparativa, se recomienda utilizar el siguiente conjunto de pruebas y criterios:

- Conjunto de prueba: 100 imágenes con diferentes escenarios (entrada, cambio de fondo, iluminación).

- Criterios: Latencia promedio, latencia p95, rendimiento, PSNR, SSIM y evaluación humana.

- Herramientas: locust o wrk para cargar; torchvision y skimage para calcular PSNR/SSIM.

Consejos finales para iniciar un negocio

Algunas sugerencias prácticas para la creación de empresas:

- Servicio SaaS con usuarios globales: Combinación de CDN, servidores GPU en varias ubicaciones clave y escalamiento automático basado en colas de solicitudes.

- Estudio y renderizado: Servidores GPU dedicados con NVLink y almacenamiento de alta velocidad para el flujo de trabajo.

- MVP o Prueba de Concepto: Utilice Nano Banana o versiones cuantificadas de Qwen en un VPS con 8–16 GB de VRAM para reducir costos.

Si desea verificar el modelo de negocio adecuado para su empresa probando el rendimiento en datos reales, nuestro equipo técnico puede proporcionarle planes y pruebas personalizados.