- Welche KI eignet sich besser zur Bilderzeugung?

- Modellübersicht (Merkmale und Schnellvergleich)

- Technische Bewertungskriterien (Latenz, Durchsatz, Qualität)

- Praktischer Leitfaden zur Serverbereitstellung (Befehle und Konfigurationen)

- Hardwareempfehlungen basierend auf Benutzer

- Unser Unternehmen: Warum eignet sich unsere Infrastruktur für diese Modelle?

- Praktische Beispiele: Pipeline für einen Flux Kontext-basierten Bildbearbeitungsdienst

- Sicherheit, Kosten und Management von Modellen

- Netzwerk- und CDN-Einstellungen für den Bildbearbeitungsdienst

- Praktische Tipps zur Auswahl eines Modells basierend auf Ihren Bedürfnissen

- Evaluierungs- und Benchmarkingmethoden (Vorschläge)

- Abschließende Ratschläge für die Unternehmensgründung

- Häufig gestellte Fragen

Welche KI eignet sich besser zur Bilderzeugung?

In diesem Artikel werden wir die vier gängigen Bildbearbeitungsmodelle in technischer und praktischer Hinsicht besprechen – Qwen, UMO, Flusskontext Und Nano-Banane — Wir prüfen es im Hinblick auf Genauigkeit, Geschwindigkeit, Ressourcenbedarf, Integrationsmöglichkeiten und den am besten geeigneten Einsatzbereich.

Modellübersicht (Merkmale und Schnellvergleich)

Im Folgenden stellen wir Ihnen die einzelnen Modelle kurz vor, um Ihnen die Auswahl des richtigen Modells entsprechend Ihren Bedürfnissen und Hardwarebeschränkungen zu erleichtern.

Qwen

Typ: Mehrzweckmodell mit Bildbearbeitungsmodulen (auf verschiedenen Ebenen: von der einfachen bis zur komplexen Bearbeitung).

Stärke: Umfassendes Kontextverständnis des Bildes und natürliche Ergebnisse bei zusammengesetzten Bearbeitungen; geeignet für hochwertige API-Dienste.

Ressourcenbedarf: Von 16 GB VRAM bei optimierten Versionen bis zu 48+ GB bei Vollversionen.

Optimale Verwendung: Bildzentrierte SaaS-Plattformen, Bildbearbeitung und detaillierte Produktion von Werbeinhalten.

UMO

Typ: Optimiertes Modell für die Einbettung und fotorealistische Restaurierung.

Stärke: Hohe Genauigkeit bei der Rekonstruktion fehlender Teile unter Beibehaltung von Beleuchtung und Textur.

Ressourcenbedarf: Für effektive Inferenz werden typischerweise 12–32 GB VRAM benötigt.

Optimale Verwendung: Fotostudios, Bildbearbeitung, Restaurierung historischer Bilder und Tools zur Einzelbildbearbeitung im Web.

Flusskontext

Typ: Kontextsensitives Aufmerksamkeitsmodell für mehrstufige und anweisungsgesteuerte Bearbeitungen.

Stärke: Koordination zwischen mehrstufigen Bearbeitungsschritten, starke Unterstützung für die Verkettung von Eingabeaufforderungen und große Kontextfenster.

Ressourcenbedarf: Vorzugsweise GPUs mit TensorRT/FP16-Unterstützung, um die Latenz zu minimieren.

Optimale Verwendung: Professionelle interaktive Bearbeitungs- und Kollaborationsanwendungen, die geringe Latenz erfordern.

Nano-Banane

Typ: Leichtes und kompaktes Modell für den Einsatz am Netzwerkrand und auf mobilen Geräten.

Stärke: Schnelle Ausführung auf GPUs mit begrenztem Speicher, geeignet für Quantisierung und INT8/4-Bit.

Ressourcenbedarf: Läuft mit 4–8 GB VRAM in quantisierten Versionen.

Optimale Verwendung: Browsererweiterungen, mobile Apps und kostengünstige VPS für ressourcenschonende Inferenz.

Technische Bewertungskriterien (Latenz, Durchsatz, Qualität)

Um das am besten geeignete Modell auszuwählen, müssen Sie vier Schlüsselkriterien messen und optimieren:

- Latenz (ms): Die Laufzeit von der Anfrage bis zur Antwort. Für die interaktive Bearbeitung des Ziels <200 ms Das heißt, größere Werte können für die Stapelverarbeitung akzeptiert werden.

- Durchsatz (Bilder/s): Anzahl der pro Zeiteinheit verarbeiteten Bilder – wichtig für Rendering und Stapelverarbeitung.

- Qualität: Quantitative Kennzahlen wie PSNR und SSIM sowie wahrnehmungsbezogene Kennzahlen wie LPIPS und FID sowie die Bewertung durch Menschen.

- Ressourceneffizienz: Der Verbrauch von VRAM, RAM, vCPU und Netzwerk-E/A bestimmt den benötigten Servertyp.

Praktischer Leitfaden zur Serverbereitstellung (Befehle und Konfigurationen)

Dieser Abschnitt bietet praktische Beispiele für die schnelle Bereitstellung von Modellen auf einem Linux-Server mit GPUs.

Server vorbereiten (NVIDIA-Treiber und Docker installieren)

sudo apt update

sudo apt install -y build-essential dkms

# install NVIDIA drivers (recommended per GPU)

sudo ubuntu-drivers autoinstall

# install Docker and nvidia-docker

curl -fsSL https://get.docker.com | sh

distribution=$(. /etc/os-release;echo $ID$VERSION_ID)

curl -s -L https://nvidia.github.io/nvidia-docker/gpgkey | sudo apt-key add -

curl -s -L https://nvidia.github.io/nvidia-docker/$distribution/nvidia-docker.list | sudo tee /etc/apt/sources.list.d/nvidia-docker.list

sudo apt update && sudo apt install -y nvidia-docker2

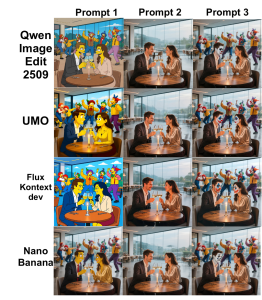

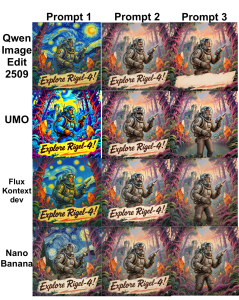

sudo systemctl restart dockerAls Beispiel- und Vergleichsbilder können Sie sich die folgenden Abbildungen ansehen:

Ausführen des Inferenzcontainer-Beispiels (mit NVIDIA-Runtime)

docker run --gpus all -it --rm \

-v /srv/models:/models \

-p 8080:8080 \

--name img-edit-infer \

myrepo/image-edit:latest \

bashInnerhalb des Containers können Sie den Inferenzdienst mit Uvicorn oder Flask ausführen:

uvicorn app:app --host 0.0.0.0 --port 8080 --workers 2Implementierung von Optimierungstipps (FP16, TensorRT, Quantisierung)

Um VRAM und Latenz zu reduzieren, können Sie Folgendes verwenden:

- FP16: Aktivieren Sie Flux Kontext und Qwen, um den VRAM-Verbrauch und die Latenz zu reduzieren. PyTorch-Beispiel:

model.half()

with torch.cuda.amp.autocast():

out = model(input)- TensorRT/ONNX: Um die Latenz zu reduzieren, werden rechenintensive Modelle in ONNX und anschließend in TensorRT umgewandelt:

python export_to_onnx.py --model qwen --output qwen.onnx

trtexec --onnx=qwen.onnx --fp16 --saveEngine=qwen.trt- Quantisierung (Nano-Banane): Verwenden Sie Bitsandbytes oder quantisierungsbewusste Methoden, um 4-Bit- oder 8-Bit-Systeme zu implementieren, die auf Edge- oder kostengünstigen VPS-Systemen ausgeführt werden können.

Hardwareempfehlungen basierend auf Benutzer

- Erste Entwicklungs- und Testphase: RTX (3060/3070) oder A2000 GPUs mit 8–12 GB VRAM.

- Hochwertiger Einsatz von Inferenz (SaaS): A10/A30 oder RTX 6000 (24 GB) für hohen Datendurchsatz.

- Training/Finetune und große Modelle (Qwen full): A100/H100 mit 40–80 GB VRAM oder Multi-GPU mit NVLink.

- Edge- und kostengünstiger VPS für Nano Banana: Server mit 8 GB VRAM oder VPS mit eGPU-Unterstützung.

Unser Unternehmen: Warum eignet sich unsere Infrastruktur für diese Modelle?

- Über 85 Standorte weltweit: Reduzierte Latenz für verteilte Teams und Endbenutzer.

- Vielseitiger Grafikserver: Von Rendering- und Inferenzkarten bis hin zur H100 für intensives Training.

- Hochleistungsfähiger Cloud-Server und BGP/CDN-Netzwerk: Geeignet für KI-Dienste, die Bandbreite und geografische Verteilung erfordern.

- Anti-DDoS-Server- und Cloud-Sicherheit: Die Verfügbarkeit der API sicherstellen und Layer-7-Angriffe verhindern.

- VPS-Tarife für Trading und Gaming: Für latenzempfindliche und Echtzeitanwendungen.

- Zusätzliche Dienstleistungen: GitLab-Hosting für CI/CD-Modelle, Rendering-Service, verwaltete Datenbanken und Netzwerklösungen.

Praktische Beispiele: Pipeline für einen Flux Kontext-basierten Bildbearbeitungsdienst

Ein vorgeschlagener Workflow für einen Bildbearbeitungsdienst umfasst die folgenden Schritte:

- Bild empfangen und Bearbeitung vom Benutzer anfordern (API).

- Vorverarbeitung: Größe anpassen, normalisieren und Segmentierungsmaske generieren.

- Senden Sie eine Anfrage an das Flux Kontext-Modell (FP16, TensorRT), um eine schnelle Vorschau zu erhalten.

- Nachbearbeitung: Farbkorrektur, Schärfung und WebP/JPEG-Ausgabe.

- Auf CDN speichern und Link zum Nutzer zurücksenden.

Beispielhafte Anfragestruktur (Pseudo):

POST /edit

{ "image_url": "...", "instructions": "remove background and enhance skin", "size":"1024" }Zielgeschwindigkeit: Latenz < 200 ms Zur Vorschau und < 2s Für ein finales, qualitativ hochwertiges Rendering (abhängig von der Hardware).

Sicherheit, Kosten und Management von Modellen

Wichtige Punkte in den Bereichen Sicherheit, Management und Kosten der Modelle:

- Datenschutz und Daten: Sensible Bilder (sowohl im Ruhezustand als auch während der Übertragung) sollten stets verschlüsselt werden. Verwenden Sie S3 mit SSE oder verwalteten Schlüsseln.

- Zugangsbeschränkungen: API-Schlüssel, Ratenbegrenzung und WAF sind für Inferenzendpunkte unerlässlich.

- Modellversionierung: Verwenden Sie eine Registry wie Harbor oder Git LFS für Modellversionen, um Rollbacks zu vereinfachen.

- Kosten: Große Modelle haben einen hohen VRAM- und Stromverbrauch; für Dienste mit hohem Lastaufkommen sollten Sie automatisch skalierende GPU-Server oder Spot-Instanzen verwenden.

Netzwerk- und CDN-Einstellungen für den Bildbearbeitungsdienst

- Nutzung von CDNs Für eine schnelle Lieferung der finalen Bilder.

- BGP und Anycast Um den Ping zu reduzieren und die Konnektivität für Nutzer weltweit zu verbessern.

- Lastverteilung mit persistenten Sitzungen Für mehrstufige Arbeitsabläufe, die eine Zustandsverwaltung erfordern.

Praktische Tipps zur Auswahl eines Modells basierend auf Ihren Bedürfnissen

- Fotorealistische Einzelbildbearbeitung (Retusche): UMO ist die beste Wahl.

- Befehlsfunktion und schrittweise Bearbeitung mit großem Kontext: Flux Kontext ist geeignet.

- Gesamtqualität und Kombination der Elemente mit ausreichenden Ressourcen: Qwen ist eine gute Wahl.

- Läuft auf Edge-Geräten oder kostengünstigen VPS: Nano Banana eignet sich zur Quantisierung.

Evaluierungs- und Benchmarkingmethoden (Vorschläge)

Für Benchmarking wird empfohlen, die folgende Testsuite und die folgenden Kriterien zu verwenden:

- Testset: 100 Bilder mit unterschiedlichen Szenarien (Inszenierung, Hintergrundänderung, Beleuchtung).

- Kriterien: Durchschnittliche Latenz, p95-Latenz, Durchsatz, PSNR, SSIM und menschliche Bewertung.

- Werkzeuge: locust oder wrk zum Laden; torchvision und skimage zur Berechnung von PSNR/SSIM.

Abschließende Ratschläge für die Unternehmensgründung

Einige praktische Vorschläge für die Unternehmensgründung:

- SaaS-Dienst mit globalen Nutzern: Die Kombination aus CDN, GPU-Servern an mehreren wichtigen Standorten und anforderungswarteschlangenbasierter automatischer Skalierung.

- Studio und Rendering: Dedizierte GPU-Server mit NVLink und Hochgeschwindigkeitsspeicher für einen reibungslosen Workflow.

- MVP oder Proof-of-Concept: Um die Kosten zu senken, verwenden Sie Nano Banana oder quantisierte Versionen von Qwen auf einem VPS mit 8–16 GB VRAM.

Wenn Sie das richtige Geschäftsmodell für Ihr Unternehmen überprüfen möchten, indem Sie die Leistung anhand realer Daten testen, kann Ihnen unser technisches Team individuelle Pläne und Tests anbieten.