- أي نوع من الذكاء الاصطناعي أفضل في إنشاء الصور؟

- نظرة عامة على الطراز (الميزات والمقارنة السريعة)

- المعايير الفنية للتقييم (زمن الاستجابة، الإنتاجية، الجودة)

- دليل عملي لنشر الخادم (الأوامر والتكوينات)

- توصيات الأجهزة بناءً على المستخدم

- شركتنا: لماذا تُعد بنيتنا التحتية مناسبة لهذه النماذج؟

- أمثلة عملية: خط أنابيب لخدمة تحرير الصور القائمة على Flux Kontext

- أمن النماذج وتكلفتها وإدارتها

- إعدادات الشبكة وشبكة توصيل المحتوى (CDN) لخدمة تحرير الصور

- نصائح عملية لاختيار طراز بناءً على احتياجاتك

- أساليب التقييم والمقارنة المعيارية (المقترحة)

- نصيحة أخيرة لبدء مشروع تجاري

- الأسئلة الشائعة

أي نوع من الذكاء الاصطناعي أفضل في إنشاء الصور؟

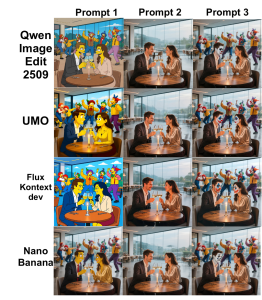

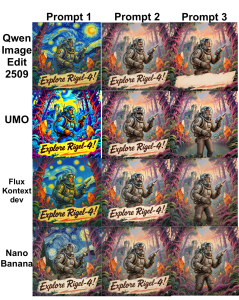

سنتناول في هذه المقالة أربعة نماذج شائعة لتحرير الصور من الناحيتين التقنية والعملية. كوين، يو إم أو، سياق التدفق و نانو بانانا — نقوم بفحصه من حيث الدقة والسرعة ومتطلبات الموارد وقدرات التكامل والاستخدام الأنسب.

نظرة عامة على الطراز (الميزات والمقارنة السريعة)

فيما يلي، نقدم بإيجاز كل نموذج لتسهيل اختيار النموذج المناسب بناءً على احتياجاتك وقيود الأجهزة لديك.

كوين

يكتب: نموذج متعدد الأغراض مزود بوحدات تحرير الصور (بمستويات مختلفة: من التحرير الأساسي إلى التحرير المعقد).

قوة: فهم سياقي واسع للصورة والمخرجات الطبيعية في عمليات التحرير المركبة؛ مناسب لخدمات واجهة برمجة التطبيقات عالية الجودة.

متطلبات الموارد: من 16 جيجابايت من ذاكرة الوصول العشوائي للفيديو للإصدارات المحسّنة إلى 48+ جيجابايت للطرازات الكاملة.

أفضل استخدام: منصات SaaS التي تركز على الصور، وعمليات التحرير المركبة، وإنتاج محتوى إعلاني مفصل.

يو إم أو

يكتب: نموذج مُحسَّن للترميم والتصوير الفوتوغرافي الواقعي.

قوة: دقة عالية في إعادة بناء الأجزاء المحذوفة، مع الحفاظ على الإضاءة والملمس.

متطلبات الموارد: عادةً ما يتطلب الأمر من 12 إلى 32 جيجابايت من ذاكرة الوصول العشوائي للفيديو (VRAM) للاستدلال الفعال.

أفضل استخدام: استوديوهات التصوير الفوتوغرافي، وخدمات تنقيح الصور، وترميم الصور التاريخية، وأدوات تحرير الصور الفردية على الإنترنت.

سياق التدفق

يكتب: نموذج انتباه واعٍ للسياق لإجراء تعديلات متعددة الخطوات وموجهة بالتعليمات.

قوة: التنسيق بين عمليات التحرير متعددة الخطوات، ودعم قوي لتسلسل المطالبات، ونوافذ سياقية كبيرة.

متطلبات الموارد: يفضل استخدام وحدات معالجة الرسومات التي تدعم TensorRT/FP16 لتقليل زمن الاستجابة.

أفضل استخدام: تطبيقات تحرير تفاعلية احترافية وتطبيقات تعاونية تتطلب زمن استجابة منخفض.

نانو بانانا

يكتب: نموذج خفيف الوزن وصغير الحجم مناسب للنشر على الحافة والتنقل.

قوة: تنفيذ سريع على وحدات معالجة الرسومات ذات الذاكرة المحدودة، مناسب للتكميم و INT8/4 بت.

متطلبات الموارد: يعمل مع ذاكرة فيديو بسعة 4-8 جيجابايت في الإصدارات الكمية.

أفضل استخدام: إضافات المتصفح، وتطبيقات الهاتف المحمول، وخوادم VPS منخفضة التكلفة للاستدلال الخفيف.

المعايير الفنية للتقييم (زمن الاستجابة، الإنتاجية، الجودة)

لاختيار النموذج الأنسب، تحتاج إلى قياس وتحسين أربعة معايير رئيسية:

- زمن الاستجابة (بالمللي ثانية): زمن المسار من الطلب إلى الاستجابة. لتحرير الهدف بشكل تفاعلي أقل من 200 مللي ثانية نعم؛ يمكن قبول قيم أكبر للمعالجة الدفعية.

- معدل النقل (صورة/ثانية): عدد الصور التي تتم معالجتها لكل وحدة زمنية - أمر مهم لخدمات العرض والمعالجة الدفعية.

- جودة: المقاييس الكمية مثل PSNR وSSIM والمقاييس الإدراكية مثل LPIPS وFID بالإضافة إلى التقييم البشري.

- كفاءة استخدام الموارد: استهلاك VRAM و RAM و vCPU واستهلاك إدخال/إخراج الشبكة، وهو ما يحدد نوع الخادم المطلوب.

دليل عملي لنشر الخادم (الأوامر والتكوينات)

يقدم هذا القسم أمثلة عملية لنشر النماذج بسرعة على خادم لينكس مزود بوحدات معالجة الرسومات.

تجهيز الخادم (تثبيت برامج تشغيل NVIDIA و Docker)

sudo apt update

sudo apt install -y build-essential dkms

# install NVIDIA drivers (recommended per GPU)

sudo ubuntu-drivers autoinstall

# install Docker and nvidia-docker

curl -fsSL https://get.docker.com | sh

distribution=$(. /etc/os-release;echo $ID$VERSION_ID)

curl -s -L https://nvidia.github.io/nvidia-docker/gpgkey | sudo apt-key add -

curl -s -L https://nvidia.github.io/nvidia-docker/$distribution/nvidia-docker.list | sudo tee /etc/apt/sources.list.d/nvidia-docker.list

sudo apt update && sudo apt install -y nvidia-docker2

sudo systemctl restart dockerللاطلاع على صور توضيحية ومقارنة، يمكنك الرجوع إلى الصور التالية:

تشغيل مثال حاوية الاستدلال (مع وقت تشغيل NVIDIA)

docker run --gpus all -it --rm \

-v /srv/models:/models \

-p 8080:8080 \

--name img-edit-infer \

myrepo/image-edit:latest \

bashداخل الحاوية، يمكنك تشغيل خدمة الاستدلال باستخدام Uvicorn أو Flask:

uvicorn app:app --host 0.0.0.0 --port 8080 --workers 2تطبيق نصائح التحسين (FP16، TensorRT، التكميم)

لتقليل زمن استجابة ذاكرة الفيديو (VRAM) وزمن الوصول، يمكنك استخدام ما يلي:

- FP16: قم بتفعيل Flux Kontext و Qwen لتقليل استهلاك ذاكرة الوصول العشوائي للفيديو (VRAM) وزمن الاستجابة. مثال باستخدام PyTorch:

model.half()

with torch.cuda.amp.autocast():

out = model(input)- TensorRT/ONNX: تحويل النماذج الثقيلة إلى ONNX ثم إلى TensorRT لتقليل زمن الاستجابة:

python export_to_onnx.py --model qwen --output qwen.onnx

trtexec --onnx=qwen.onnx --fp16 --saveEngine=qwen.trt- التكميم (الموزة النانوية): استخدم طرق bitsandbytes أو الطرق الواعية بالتكميم لتنفيذ 4 بت أو 8 بت للتشغيل على الحافة أو VPS منخفض التكلفة.

توصيات الأجهزة بناءً على المستخدم

- التطوير والاختبار الأولي: وحدات معالجة الرسومات RTX (3060/3070) أو A2000 مع ذاكرة وصول عشوائي للفيديو (VRAM) بسعة 8-12 جيجابايت.

- نشر الاستدلال عالي الجودة (البرمجيات كخدمة): A10/A30 أو RTX 6000 (24GB) لإنتاجية عالية.

- التدريب/الضبط والنماذج الكبيرة (كوين كاملة): A100/H100 مع ذاكرة وصول عشوائي للفيديو (VRAM) بسعة 40-80 جيجابايت أو معالج رسومات متعدد مع NVLink.

- خادم افتراضي خاص منخفض التكلفة وحافة مخصصة لـ Nano Banana: خوادم مزودة بذاكرة وصول عشوائي للفيديو سعة 8 جيجابايت أو خوادم افتراضية خاصة تدعم وحدة معالجة الرسومات الخارجية (eGPU).

شركتنا: لماذا تُعد بنيتنا التحتية مناسبة لهذه النماذج؟

- أكثر من 85 موقعًا حول العالم: تقليل زمن الاستجابة للفرق الموزعة والمستخدمين النهائيين.

- خوادم رسومات متنوعة: من بطاقات العرض والاستدلال إلى جهاز H100 للتدريب المكثف.

- خادم سحابي عالي الأداء وشبكة BGP/CDN: مناسب لخدمات الذكاء الاصطناعي التي تتطلب عرض نطاق ترددي وتوزيع جغرافي.

- حماية الخوادم والحوسبة السحابية من هجمات DDoS: الحفاظ على توافر واجهة برمجة التطبيقات ومنع هجمات الطبقة السابعة.

- خطط خوادم افتراضية خاصة للتداول والألعاب: للتطبيقات الحساسة للتأخير والتطبيقات التي تعمل في الوقت الفعلي.

- خدمات إضافية: استضافة GitLab لنماذج التكامل المستمر/التسليم المستمر، وخدمة العرض، وقاعدة البيانات المُدارة، وحلول الشبكات.

أمثلة عملية: خط أنابيب لخدمة تحرير الصور القائمة على Flux Kontext

تتضمن آلية العمل المقترحة لخدمة تحرير الصور الخطوات التالية:

- استلام الصورة وطلب التعديل من المستخدم (واجهة برمجة التطبيقات).

- المعالجة المسبقة: تغيير الحجم، والتطبيع، وإنشاء قناع التجزئة.

- أرسل إلى نموذج Flux Kontext (FP16، TensorRT) للحصول على معاينة سريعة.

- المعالجة اللاحقة: تصحيح الألوان، والتوضيح، وإخراج الصور بصيغة WebP/JPEG.

- قم بتخزينه على شبكة توصيل المحتوى (CDN) وأعد الرابط إلى المستخدم.

نموذج لهيكل الطلب (وهمي):

POST /edit

{ "image_url": "...", "instructions": "remove background and enhance skin", "size":"1024" }السرعة المستهدفة: زمن الاستجابة < 200 مللي ثانية للمعاينة و أقل من 2 ثانية للحصول على عرض نهائي عالي الجودة (حسب مواصفات الجهاز).

أمن النماذج وتكلفتها وإدارتها

النقاط الرئيسية في مجالات الأمن والإدارة وتكلفة النماذج:

- الخصوصية والبيانات: قم دائمًا بتشفير الصور الحساسة (المخزنة والمنقولة) واستخدم S3 مع SSE أو المفاتيح المُدارة.

- قيود الوصول: تُعد مفاتيح واجهة برمجة التطبيقات (API Keys) وتحديد معدل الطلبات وجدار حماية تطبيقات الويب (WAF) عناصر أساسية لنقاط نهاية الاستدلال.

- إصدار النموذج: استخدم سجلًا مثل Harbor أو Git LFS لإصدارات النماذج لتسهيل عملية التراجع.

- يكلف: تتميز النماذج الكبيرة باستهلاك عالٍ لذاكرة الوصول العشوائي للفيديو والطاقة؛ بالنسبة للخدمات ذات الأحمال المتقطعة، استخدم خوادم وحدة معالجة الرسومات ذاتية التوسع أو مثيلات Spot.

إعدادات الشبكة وشبكة توصيل المحتوى (CDN) لخدمة تحرير الصور

- استخدام شبكات توصيل المحتوى (CDNs) لتسليم الصور النهائية بسرعة.

- BGP و Anycast لتقليل زمن الاستجابة (ping) وتحسين الاتصال للمستخدمين العالميين.

- موازن الأحمال مع جلسات ثابتة لسير العمل متعدد الخطوات الذي يتطلب صيانة الحالة.

نصائح عملية لاختيار طراز بناءً على احتياجاتك

- تحرير الصور الواقعية (التنقيح): يُعدّ UMO الخيار الأفضل.

- إمكانية التحكم والتعديلات خطوة بخطوة مع سياق واسع: يُعد Flux Kontext مناسبًا.

- الجودة الشاملة وتكامل العناصر مع الموارد الكافية: كوين خيار قوي.

- التشغيل على الأجهزة الطرفية أو خوادم افتراضية خاصة منخفضة التكلفة: يُعدّ نانو بانانا مناسبًا للقياس الكمي.

أساليب التقييم والمقارنة المعيارية (المقترحة)

لأغراض المقارنة المعيارية، يوصى باستخدام مجموعة الاختبارات والمعايير التالية:

- مجموعة الاختبار: 100 صورة مع سيناريوهات مختلفة (التصوير، تغيير الخلفية، الإضاءة).

- معايير: متوسط زمن الاستجابة، زمن الاستجابة عند النسبة المئوية 95، الإنتاجية، نسبة الإشارة إلى الضوضاء، مؤشر التشابه الهيكلي، والتقييم البشري.

- أدوات: locust أو wrk للتحميل؛ torchvision و skimage لحساب PSNR/SSIM.

نصيحة أخيرة لبدء مشروع تجاري

بعض الاقتراحات العملية لتأسيس الأعمال التجارية:

- خدمة SaaS مع مستخدمين عالميين: الجمع بين شبكة توصيل المحتوى (CDN) وخوادم وحدة معالجة الرسومات (GPU) في عدة مواقع رئيسية، والتوسع التلقائي القائم على قائمة انتظار الطلبات.

- الاستوديو والإخراج: خوادم مخصصة لوحدات معالجة الرسومات مع تقنية NVLink ووحدات تخزين عالية السرعة لسير العمل.

- المنتج الأولي أو إثبات المفهوم: استخدم Nano Banana أو الإصدارات الكمية من Qwen على خادم افتراضي خاص (VPS) مزود بذاكرة وصول عشوائي للفيديو (VRAM) بسعة 8-16 جيجابايت لتقليل التكاليف.

إذا كنت ترغب في التحقق من نموذج العمل المناسب لعملك من خلال اختبار الأداء على بيانات حقيقية، فيمكن لفريقنا التقني تقديم خطط واختبارات مخصصة.